라즈베리 파이를 위한 7가지 작은 AI 모델

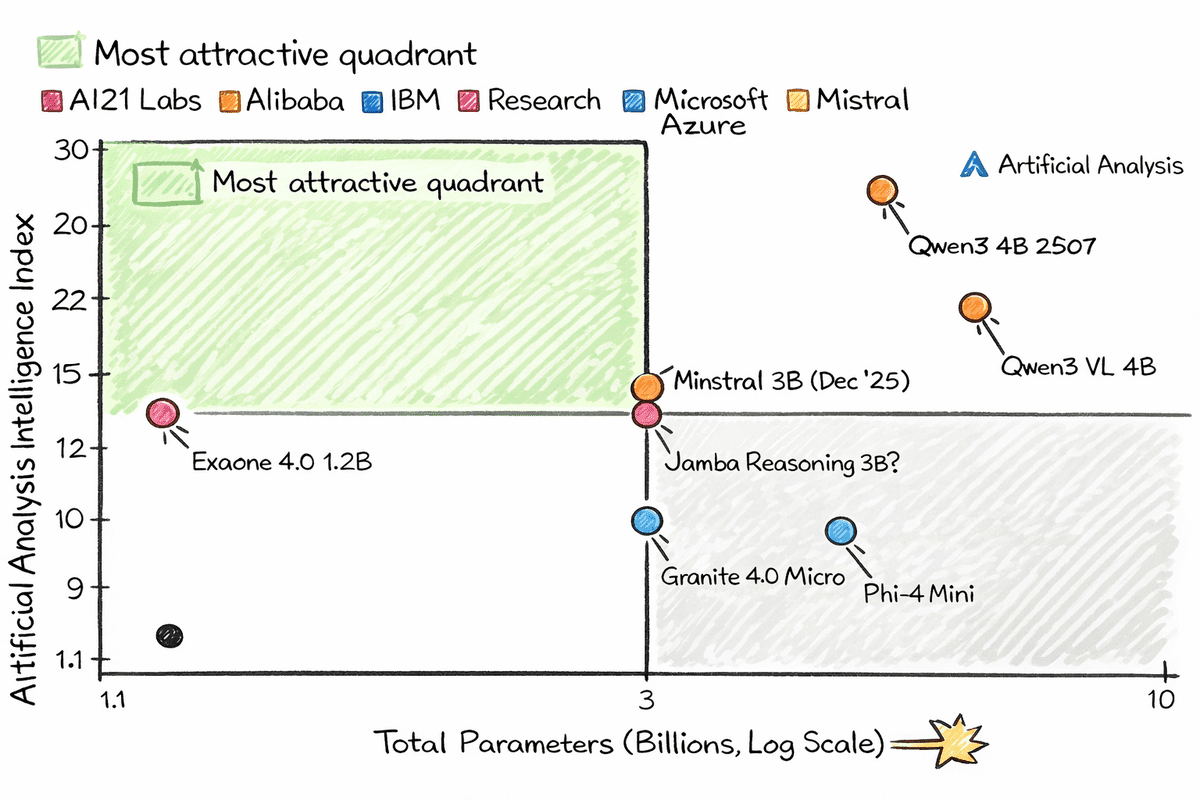

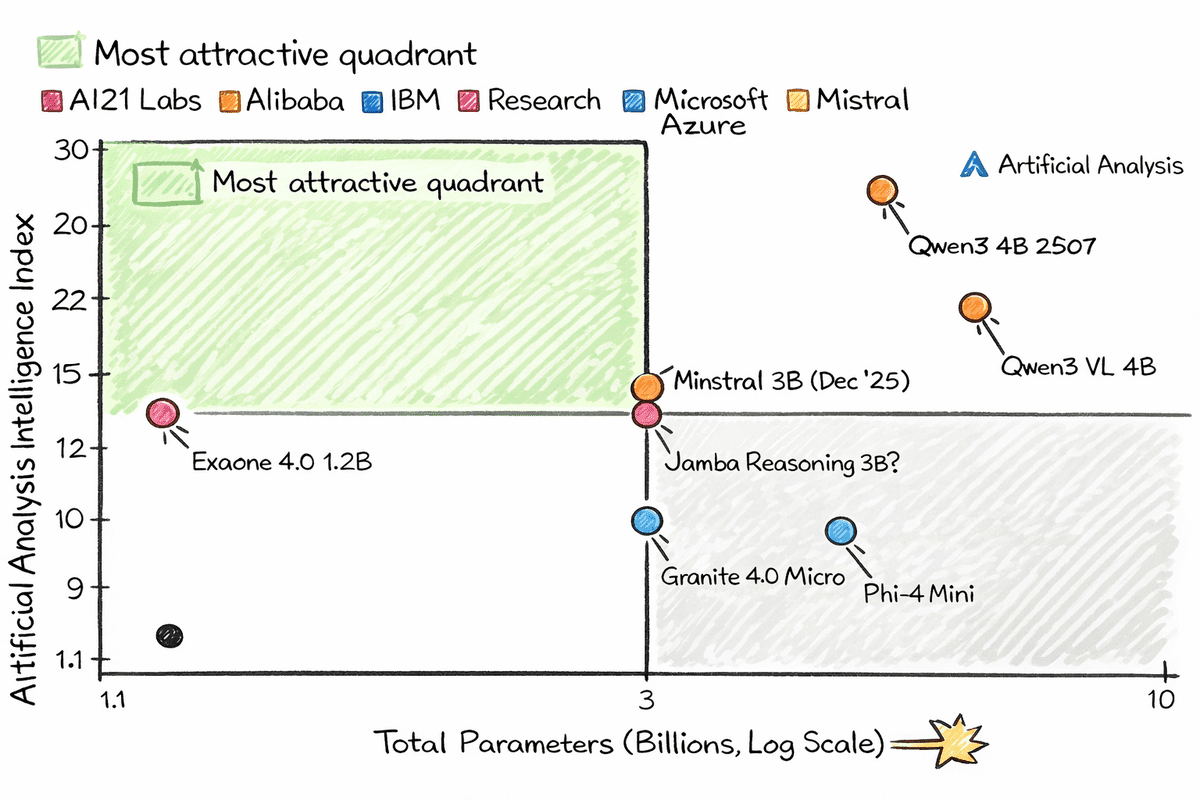

인공 분석 기반 이미지

# 소개

우리는 종종 작은 AI 모델에 대해 이야기합니다. 하지만 CPU 성능이 제한되고 RAM이 거의 없는 Raspberry Pi에서 실제로 실행될 수 있는 작은 모델은 어떻습니까?

현대적인 아키텍처와 공격적인 양자화 덕분에 이제 약 10억~20억 개의 매개변수가 있는 모델을 매우 작은 장치에서 실행할 수 있습니다. 양자화하면 이러한 모델은 스마트 냉장고를 비롯한 거의 모든 곳에서 실행할 수 있습니다. Hugging Face Hub의 양자화된 모델인 llama.cpp와 시작하기 위한 간단한 명령만 있으면 됩니다.

이 작은 모델을 흥미롭게 만드는 것은 약하거나 구식이 아니라는 것입니다. 이들 중 다수는 실제 텍스트 생성에서 훨씬 오래된 대형 모델보다 성능이 뛰어납니다. 일부는 도구 호출, 비전 이해 및 구조화된 출력도 지원합니다. 이들은 작고 멍청한 모델이 아닙니다. 그들은 작고 빠르며 놀랍도록 지능적이며 손바닥에 맞는 장치에서 실행할 수 있습니다.

이 기사에서는 llama.cpp를 사용하여 Raspberry Pi 및 기타 저전력 기계에서 잘 실행되는 7개의 작은 AI 모델을 살펴보겠습니다. GPU, 클라우드 비용 또는 과도한 인프라 없이 로컬 AI를 실험하고 싶다면 이 목록을 시작하는 것이 좋습니다.

# 1. 퀀3 4B 2507

Qwen3-4B-Instruct-2507은 크기에 비해 성능이 크게 향상되는 작지만 뛰어난 기능을 갖춘 비사고 언어 모델입니다. 단 40억 개의 매개변수를 사용하여 지침 따르기, 논리적 추론, 수학, 과학, 코딩 및 도구 사용 전반에 걸쳐 강력한 향상을 보여 주는 동시에 여러 언어에 걸쳐 롱테일 지식 범위를 확장합니다.

이 모델은 주관적이고 개방형 작업에서 사용자 선호도에 대한 정렬이 눈에 띄게 개선되어 더 명확하고 유용하며 품질이 높은 텍스트 생성이 가능함을 보여줍니다. 인상적인 256K 기본 컨텍스트 길이 지원을 통해 매우 긴 문서와 대화를 효율적으로 처리할 수 있으므로 더 큰 모델의 오버헤드 없이 깊이와 속도를 모두 요구하는 실제 애플리케이션에 실용적인 선택이 됩니다.

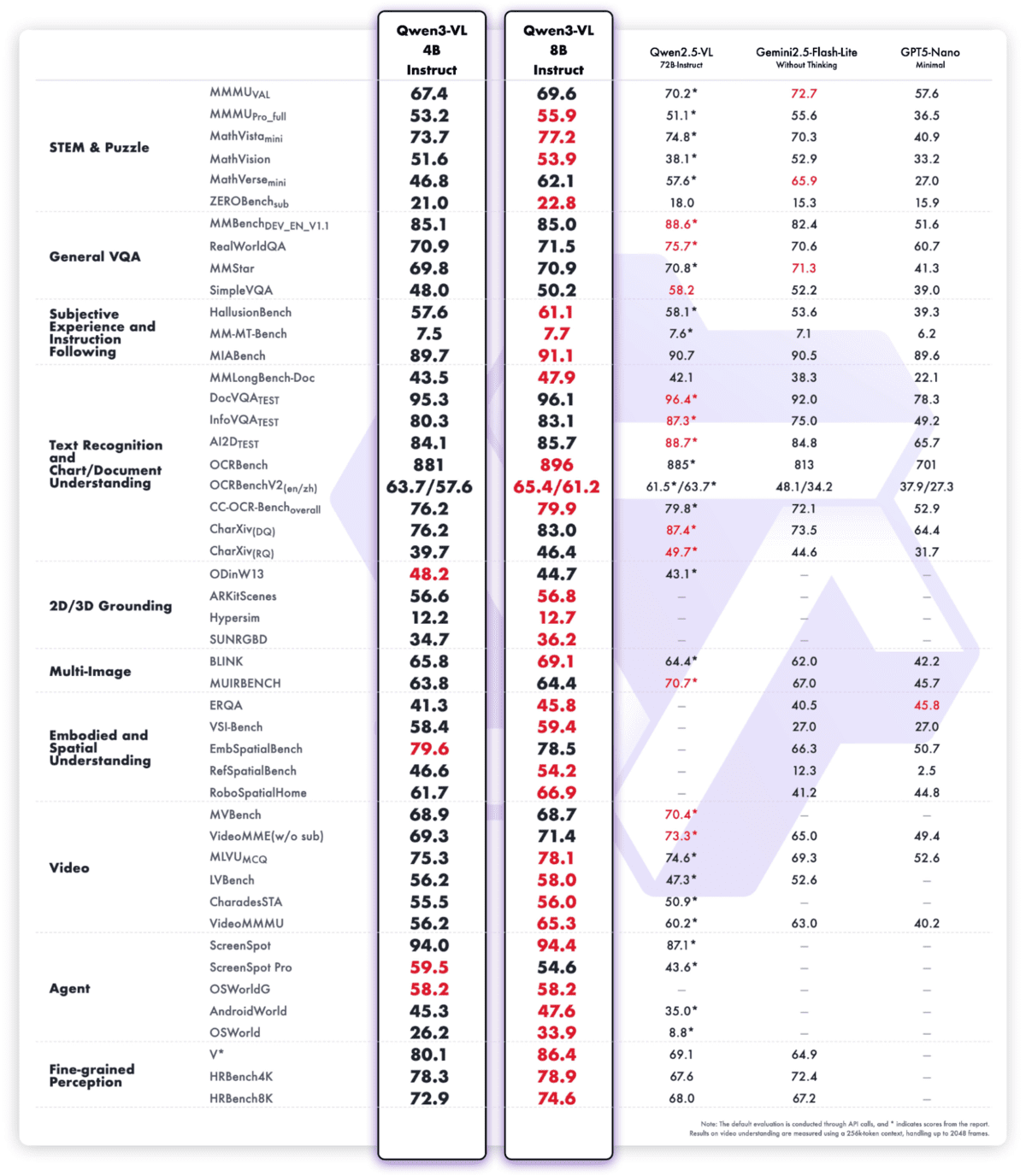

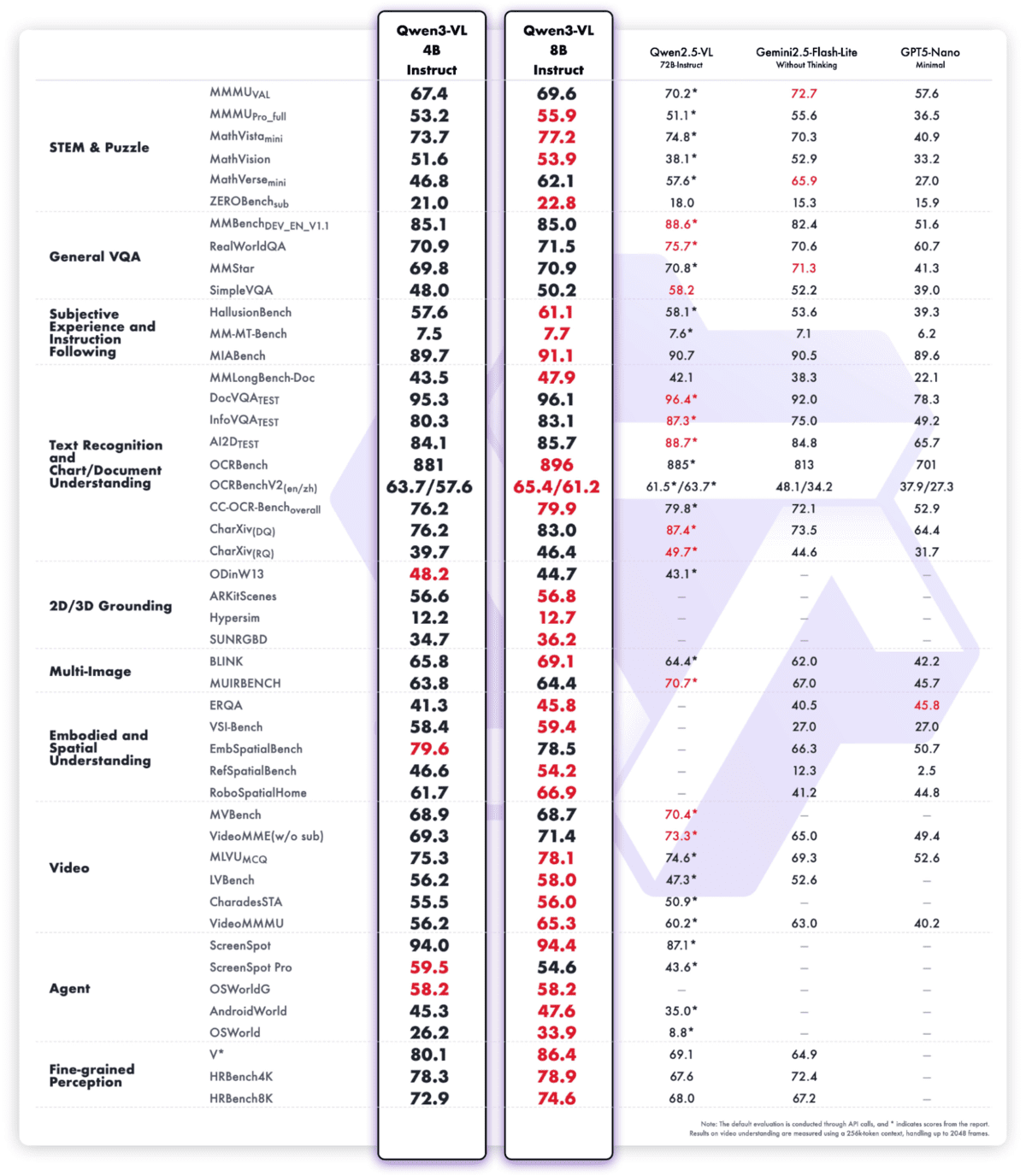

# 2. Qwen3 VL 4B

Qwen3‑VL‑4B‑Instruct는 현재까지 Qwen 제품군 중 가장 발전된 비전 언어 모델로, 최첨단 다중 모드 지능을 매우 효율적인 4B 매개변수 폼 팩터에 담았습니다. 이는 더 깊은 시각적 인식, 추론 및 공간 인식과 결합되어 뛰어난 텍스트 이해 및 생성을 제공하여 이미지, 비디오 및 긴 문서 전반에 걸쳐 강력한 성능을 가능하게 합니다.

이 모델은 기본 256K 컨텍스트(1M까지 확장 가능)를 지원하므로 정확한 리콜과 세밀한 시간 인덱싱을 통해 전체 책이나 몇 시간 길이의 비디오를 처리할 수 있습니다. Interleaved-MRoPE, DeepStack 시각적 융합, 정밀한 텍스트-타임스탬프 정렬과 같은 아키텍처 업그레이드로 장수평 비디오 추론, 세밀한 세부 인식 및 이미지-텍스트 접지가 크게 향상됩니다.

인식을 넘어서 Qwen3‑VL‑4B‑Instruct는 PC 및 모바일 GUI를 작동하고, 도구를 호출하고, 시각적 코드(HTML/CSS/JS, Draw.io)를 생성하고, 텍스트와 비전에 기반한 추론을 통해 복잡한 다중 모달 워크플로를 처리할 수 있는 시각적 에이전트 역할을 합니다.

# 3. 엑사원 4.0 1.2B

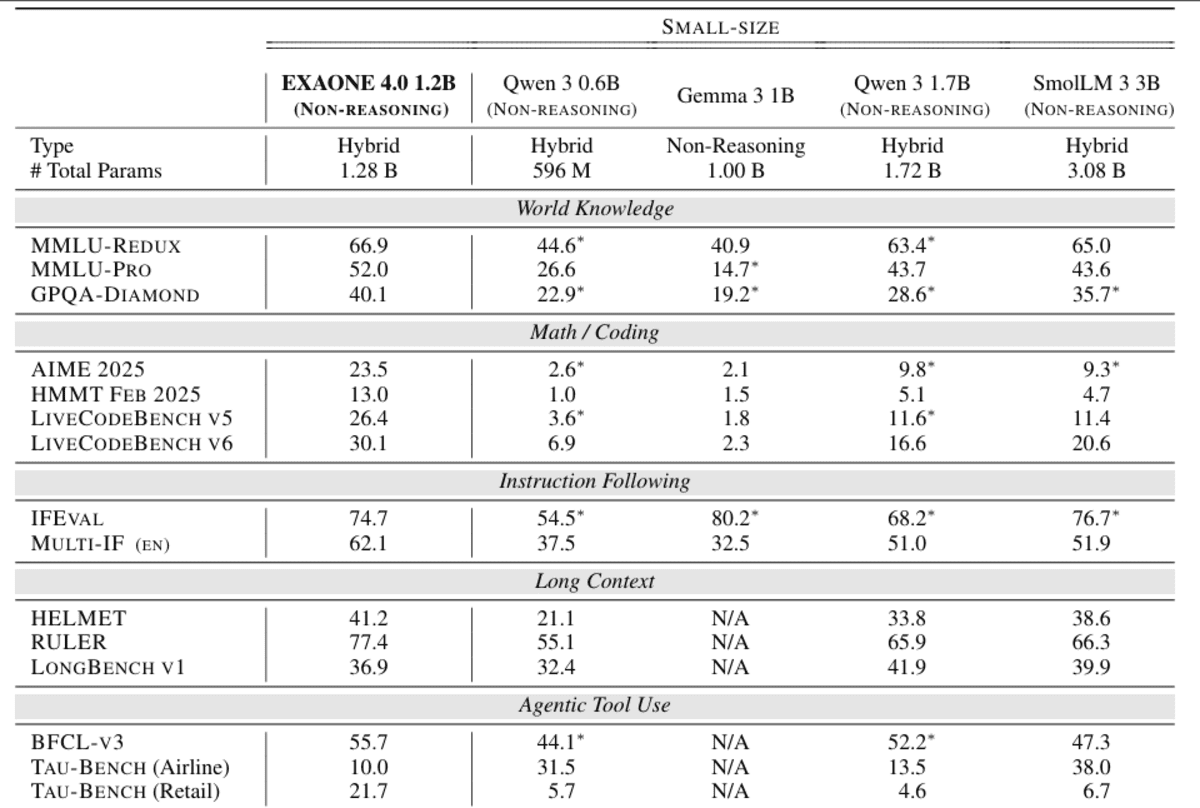

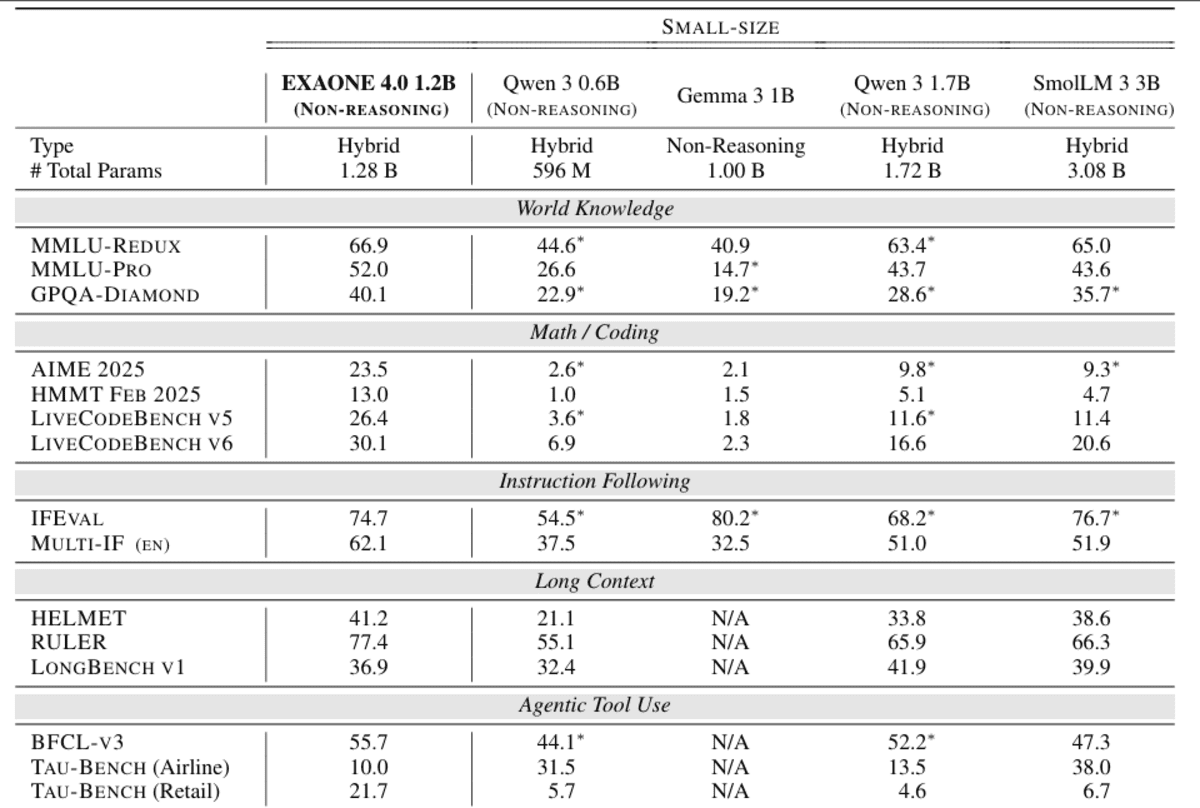

EXAONE 4.0 1.2B는 에이전트 AI 및 하이브리드 추론을 매우 리소스 효율적으로 배포하도록 설계된 소형의 온디바이스 친화적인 언어 모델입니다. 빠르고 실용적인 응답을 위한 비추론 모드와 복잡한 문제 해결을 위한 선택적 추론 모드를 모두 통합하여 개발자가 단일 모델 내에서 속도와 깊이를 동적으로 절충할 수 있습니다.

작은 크기에도 불구하고 1.2B 변형은 에이전트 도구 사용을 지원하여 함수 호출 및 자율 작업 실행을 지원하고 영어, 한국어 및 스페인어로 다국어 기능을 제공하여 단일 언어 엣지 애플리케이션 이상으로 유용성을 확장합니다.

구조적으로는 하이브리드 어텐션 및 향상된 정규화 방식과 같은 EXAONE 4.0의 고급 기능을 계승하는 동시에 64K 토큰 컨텍스트 길이를 지원하므로 이 규모의 장기 컨텍스트 이해에 매우 강력합니다.

효율성을 위해 최적화된 이 제품은 메모리 공간과 대기 시간이 모델 품질만큼 중요한 온디바이스 및 저비용 추론 시나리오에 명시적으로 포지셔닝됩니다.

# 4. 미니스트럴 3B

Ministral-3-3B-Instruct-2512는 Ministral 3 제품군 중 가장 작은 구성원이며 에지 및 저자원 배포용으로 특별히 제작된 매우 효율적인 초소형 다중 모드 언어 모델입니다. 시스템 프롬프트와 구조화된 출력을 강력하게 유지하면서 채팅 및 지시에 따른 워크로드에 특별히 최적화된 FP8 지시 미세 조정 모델입니다.

구조적으로 3.4B 매개변수 언어 모델과 0.4B 비전 인코더를 결합하여 텍스트 추론과 함께 기본 이미지 이해를 지원합니다.

컴팩트한 크기에도 불구하고 이 모델은 256K의 큰 컨텍스트 창, 수십 개 언어에 대한 강력한 다국어 지원, 함수 호출 및 JSON 출력과 같은 기본 에이전트 기능을 지원하므로 실시간, 임베디드 및 분산 AI 시스템에 매우 적합합니다.

FP8의 8GB VRAM(양자화할 경우 더 적음)에 맞도록 설계된 Ministral 3 3B Instruct는 성능 저하 없이 효율성을 요구하는 생산 사용 사례에 대해 강력한 와트당 및 달러당 성능을 제공합니다.

# 5. 잠바추리 3B

Jamba-Reasoning-3B는 작은 설치 공간에서 강력한 인텔리전스, 긴 컨텍스트 처리 및 높은 효율성을 제공하도록 설계된 작지만 뛰어난 기능을 갖춘 30억 매개변수 추론 모델입니다.

정의적인 혁신은 하이브리드 Transformer-Mamba 아키텍처로, 소수의 어텐션 레이어가 복잡한 종속성을 포착하고 대부분의 레이어는 매우 효율적인 시퀀스 처리를 위해 Mamba 상태공간 모델을 사용합니다.

이 디자인은 메모리 오버헤드를 크게 줄이고 처리량을 향상시켜 모델이 품질 저하 없이 노트북, GPU, 심지어 모바일급 장치에서도 원활하게 실행될 수 있도록 해줍니다.

크기에도 불구하고 Jamba Reasoning 3B는 256K 토큰 컨텍스트를 지원하여 대규모 어텐션 캐시에 의존하지 않고 매우 긴 문서로 확장하므로 긴 컨텍스트 추론을 실용적이고 비용 효율적으로 만듭니다.

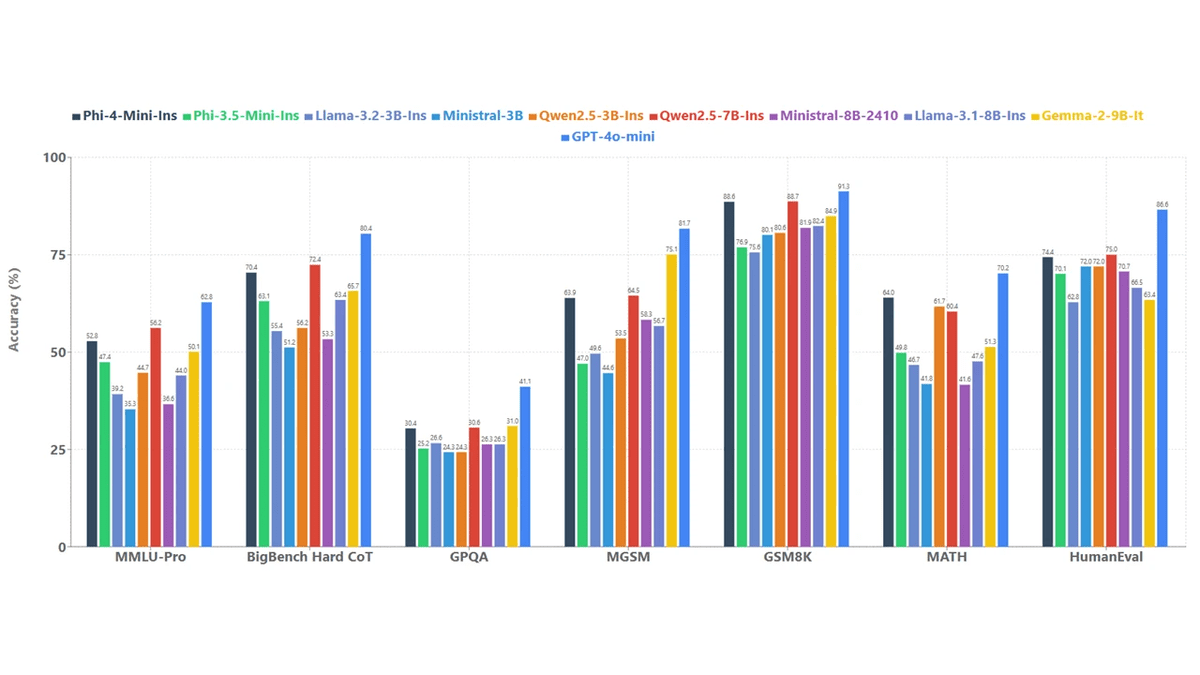

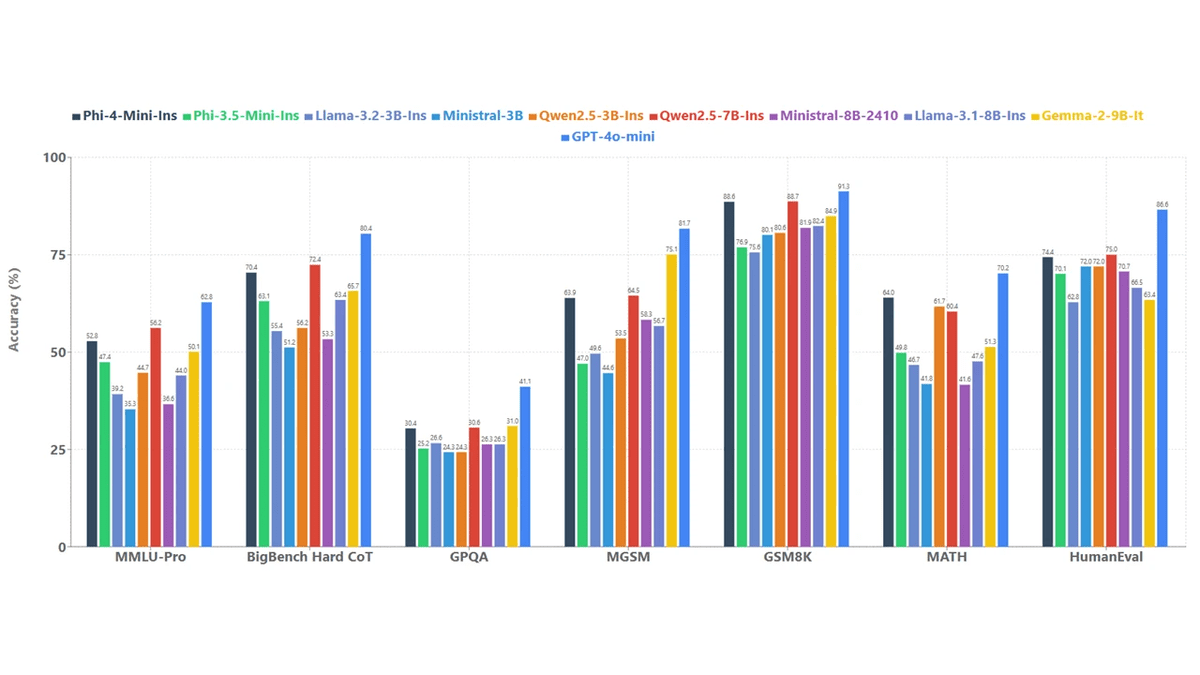

지능 벤치마크에서는 여러 평가를 포괄하는 통합 점수에서 Gemma 3 4B 및 Llama 3.2 3B와 같은 유사한 소형 모델을 능가하며 동급 대비 유난히 강력한 추론 능력을 보여줍니다.

# 6. 화강암 4.0 마이크로

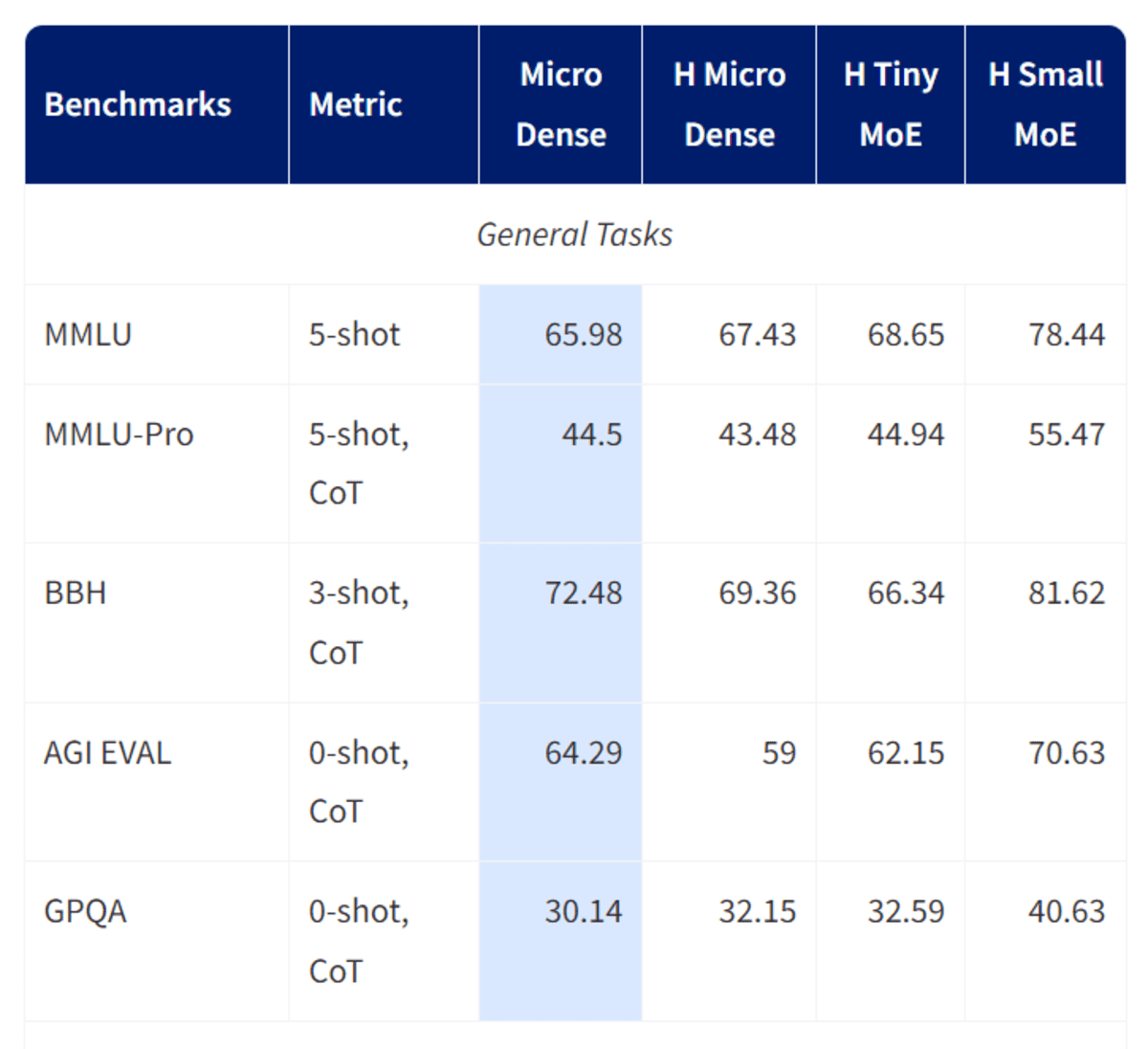

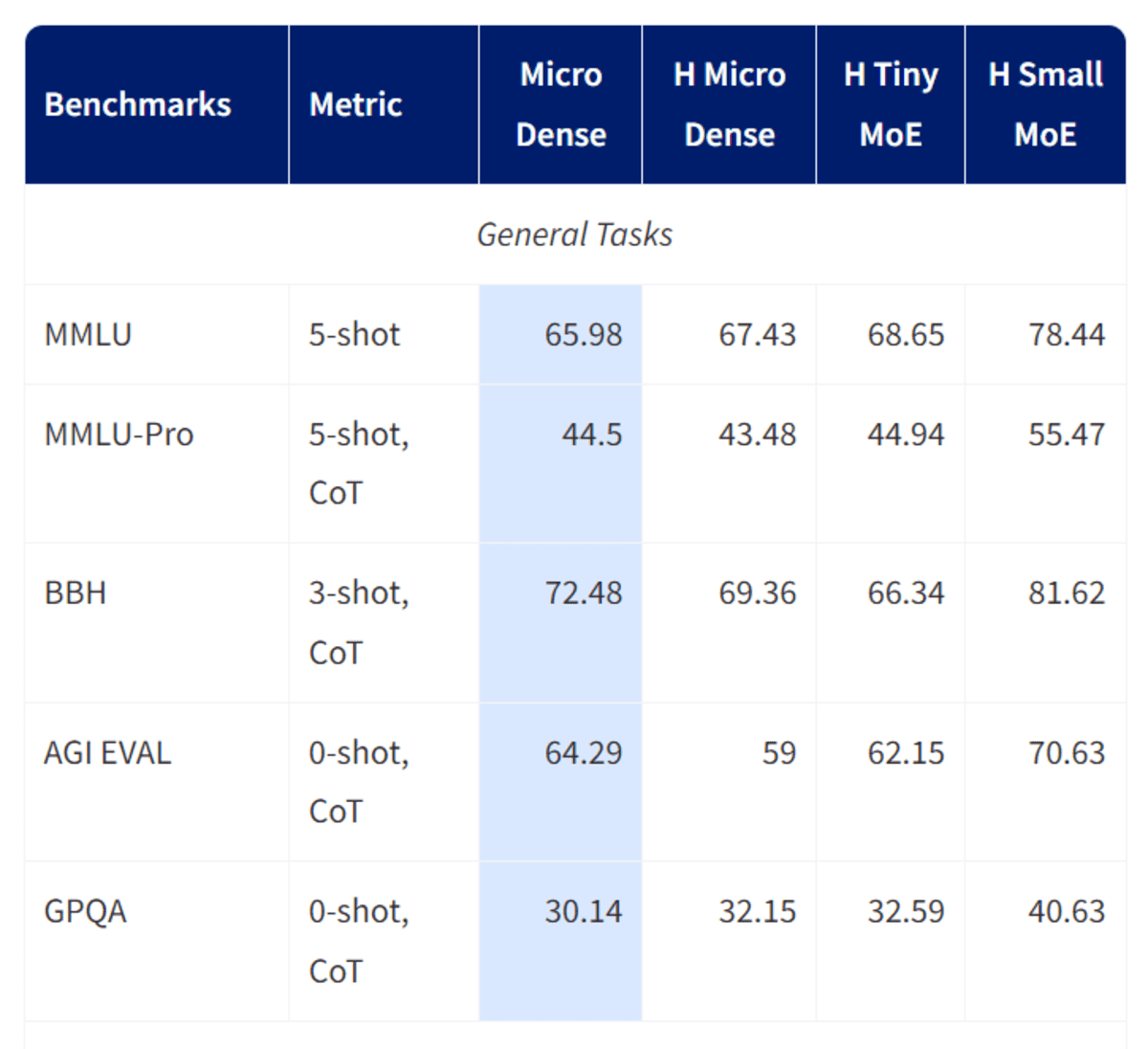

Granite-4.0-micro는 IBM Granite 팀이 개발하고 엔터프라이즈급 보조자 및 에이전트 워크플로우를 위해 특별히 설계된 3B 매개변수 긴 컨텍스트 명령 모델입니다.

허용된 라이선스가 부여된 공개 데이터 세트와 고품질 합성 데이터를 혼합하여 Granite‑4.0‑Micro‑Base에서 미세 조정되었으며, 2025년 10월 업데이트에 추가된 기본 시스템 프롬프트로 강화된 안정적인 지시 따르기, 전문적인 어조 및 안전한 응답을 강조합니다.

이 모델은 매우 큰 128K 컨텍스트 창, 강력한 도구 호출 및 함수 실행 기능, 주요 유럽, 중동 및 동아시아 언어에 걸친 광범위한 다국어 지원을 지원합니다.

GQA, RoPE, SwiGLU MLP 및 RMSNorm과 같은 최신 구성 요소를 갖춘 고밀도 디코더 전용 변환기 아키텍처를 기반으로 구축된 Granite‑4.0‑Micro는 견고성과 효율성의 균형을 유지하므로 Apache 2.0 오픈 소스 라이선스에 따라 외부 시스템과 깔끔하게 통합되어야 하는 비즈니스 애플리케이션, RAG 파이프라인, 코딩 작업 및 LLM 에이전트를 위한 기반 모델로 매우 적합합니다.

# 7. 파이-4 왓

Phi-4-mini-instruct는 엄격한 메모리 및 컴퓨팅 제약 조건 하에서 강력한 추론 및 명령 따르기 성능을 제공하도록 설계된 Microsoft의 경량 개방형 3.8B 매개변수 언어 모델입니다.

밀도가 높은 디코더 전용 Transformer 아키텍처를 기반으로 구축된 이 제품은 기본적으로 사실적 암기보다 추론 밀도가 높은 콘텐츠에 중점을 두고 고품질의 합성 “교과서 같은” 데이터와 세심하게 필터링된 공개 소스에 대해 주로 훈련됩니다.

이 모델은 128K 토큰 컨텍스트 창을 지원하므로 이 규모에서는 흔하지 않은 긴 문서 이해와 확장된 대화가 가능합니다.

사후 교육은 감독된 미세 조정과 직접적인 선호도 최적화를 결합하여 정확한 지침 준수, 강력한 안전 동작 및 효과적인 기능 호출을 구현합니다.

200,000개의 대규모 토큰 어휘와 광범위한 다국어 적용 범위를 갖춘 Phi-4-mini-instruct는 특히 메모리 또는 컴퓨팅이 제한된 환경에서 대기 시간, 비용 및 추론 품질의 균형을 유지해야 하는 연구 및 생산 시스템을 위한 실용적인 빌딩 블록으로 자리잡고 있습니다.

# 최종 생각

작은 모델은 더 이상 크기가 기능의 제한이 아닌 지점에 도달했습니다. Qwen 3 시리즈는 이 목록에서 두각을 나타내며 훨씬 더 큰 언어 모델에 필적하고 일부 독점 시스템에도 도전하는 성능을 제공합니다. Raspberry Pi 또는 기타 저전력 장치용 애플리케이션을 구축하는 경우 Qwen 3은 훌륭한 출발점이 되며 설정에 통합할 가치가 있습니다.

Qwen 외에도 EXAONE 4.0 1.2B 모델은 추론과 중요하지 않은 문제 해결에 특히 강력하면서도 대부분의 대안보다 훨씬 작습니다. Ministral 3B는 또한 업데이트된 지식 컷오프와 견고한 범용 성능을 제공하는 해당 시리즈의 최신 릴리스로 주목받을 가치가 있습니다.

전반적으로 이러한 모델 중 다수는 인상적이지만 속도, 정확성 및 도구 호출을 우선순위로 두는 경우 Qwen 3 LLM 및 VLM 변형을 이기기가 어렵습니다. 이는 작은 온디바이스 AI가 얼마나 멀리 왔는지, 그리고 왜 작은 하드웨어에 대한 로컬 추론이 더 이상 타협이 되지 않는지를 명확하게 보여줍니다.

아비드 알리 아완 (@1abidaliawan)은 기계 학습 모델 구축을 좋아하는 공인 데이터 과학자 전문가입니다. 현재 그는 콘텐츠 제작에 집중하고 있으며 기계 학습 및 데이터 과학 기술에 대한 기술 블로그를 작성하고 있습니다. Abid는 기술 관리 석사 학위와 통신 공학 학사 학위를 보유하고 있습니다. 그의 비전은 정신 질환으로 어려움을 겪고 있는 학생들을 위해 그래프 신경망을 사용하여 AI 제품을 구축하는 것입니다.

Post Comment