언어 모델 미세 조정에 대한 간략한 요약

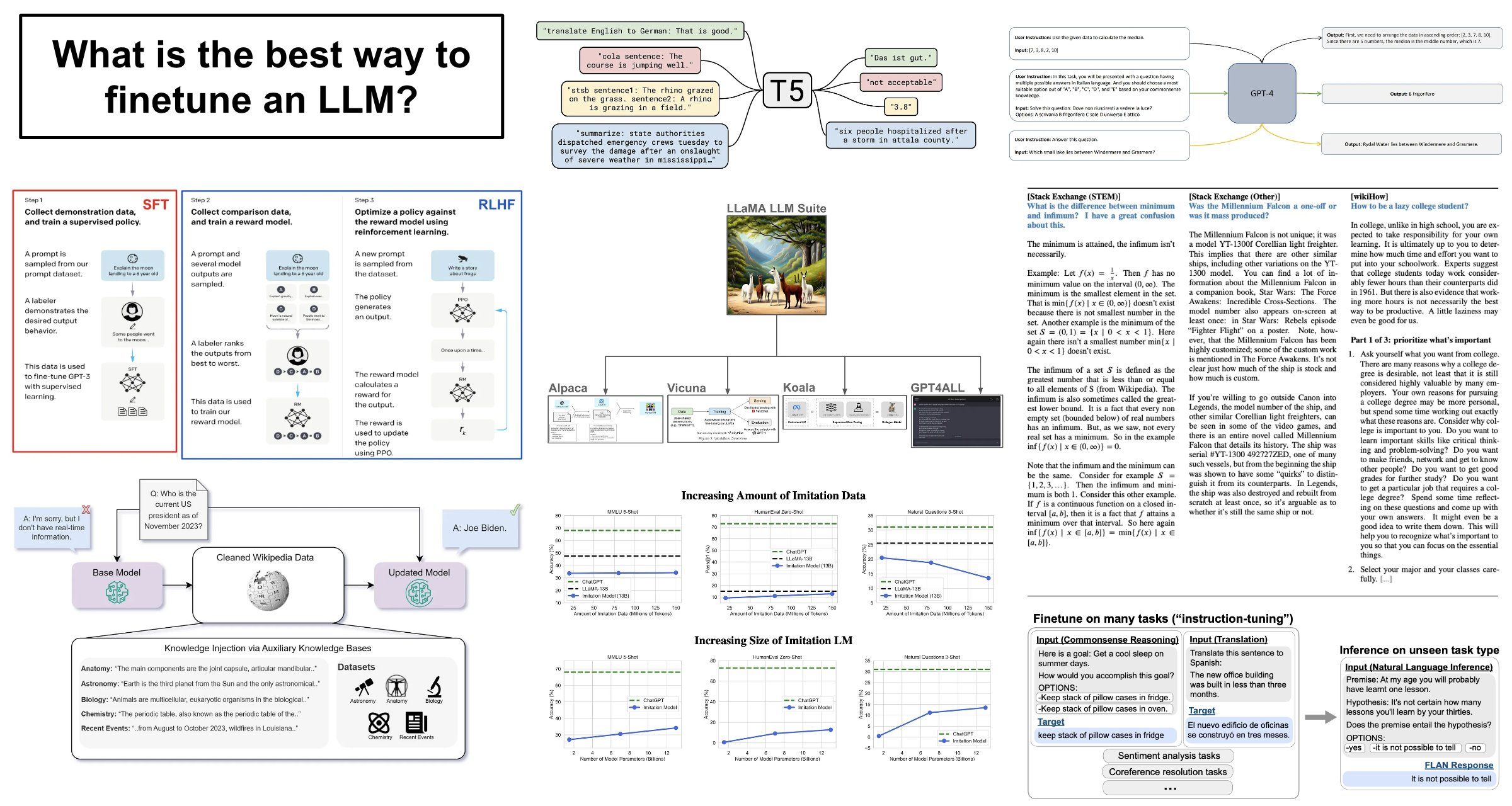

Fine-tuning techniques: The term “fine tuning” refers to further training a pretrained model. In the case of LLMs, this means that we take a pretrained foundation model and train it some more. But, there are so many different ways that this training can be done, which makes the concept of fine tuning incredibly vague. This single term can refer to a variety of different techniques, such as:

- Continued pretraining

- Instruction tuning

- Supervised fine tuning (SFT)

- Reinforcement Learning from Human Feedback (RLHF) or Direct Preference Optimization (DPO)

What is the goal of these techniques? For language models, there are two primary goals that a practitioner will have when performing fine tuning:

- Knowledge injection: Teach the model how to leverage new sources of knowledge (not present during pretraining) when solving problems.

- Alignment (or style/format specification): Modify the way in which the language model surfaces its existing knowledge base; e.g., abide by a certain answer format, use a new style/tone of voice, avoid outputting incorrect information, and more.

Given this information, we might wonder: Which fine-tuning techniques should we use to accomplish either (or both) of these goals? To answer this question, we need to take a much deeper look at recent research on the topic of fine tuning.

Large-scale instruction tuning: Prior to the release of modern open-source LLMs, it was very common to fine tune pretrained LLMs on massive instruction tuning datasets. Such an approach was popularized by models like FLAN [1] (Google에서) 대규모 데이터 세트에 대해 사전 학습된 언어 모델의 명령 조정을 수행합니다. 예를 들어 FLAN의 경우 FLANv2 명령어 튜닝 데이터 세트에는 1,500만 개가 넘는 예제가 포함되어 있습니다. 이는 매우 큰 규모입니다! 이 접근 방식을 따르면 FLAN은 다양한 다운스트림 작업을 효율적인 방식으로 해결하는 방법을 배울 수 있습니다.

“우리는 이러한 지침에 따라 모델을 훈련함으로써 훈련 중에 본 지침을 해결하는 데 능숙해질 뿐만 아니라 일반적인 지침을 따르는 데에도 능숙해진다는 것을 보여줍니다.” – FLAN 종이에서 [1]

지식 주입을 넘어서: ChatGPT 제안 이후, 언어 모델을 정렬하고 출력 형식을 특정 스타일이나 구조에 맞게 조정하려는 욕구가 증가하는 것을 확인했습니다. 이러한 목표는 새로운 과제를 해결하기 위해 LLM을 가르치는 것과 크게 다릅니다. LLM에게 새로운 지식을 가르치려고 할 때 더 많은 데이터가 항상 더 좋습니다(따라서 FLAN과 같은 모델에서 사용되는 대규모 명령 튜닝 데이터 세트). 그러나 언어 모델을 특정 스타일이나 출력 구조에 맞추는 데 새로운 정보를 배울 필요는 없습니다! 따라서 정렬 중심 목표에는 덜 광범위한 미세 조정이 필요할 수 있습니다.

정렬에는 적을수록 좋습니다. LLM 미세 조정 주제에 대한 연구는 LLaMA 출시로 촉진되었습니다. [2] (그리고 나중에 LLaMA-2 [3]), 이를 통해 고품질 기초 LLM을 공개적으로 사용할 수 있게 되었습니다. LLaMA 이후 곧 Meta의 저자들이 LIMA를 출판했습니다. [4]이는 정렬 스타일의 미세 조정이 매우 적은 데이터로 수행될 수 있음을 보여주었습니다. 즉, 정렬의 목표는 (새로운 정보를 배우는 것이 아니라) LLM의 스타일을 적용하는 것이며, 이는 작고 고품질의 다양한 미세 조정 데이터 세트를 통해 수행할 수 있습니다. 이러한 연구 결과에 따르면 LLM 지식의 대부분은 사전 교육에서 비롯되며 LLM은 정렬 중에 올바른 스타일을 학습한다는 사실이 밝혀졌습니다(아래 인용문 참조).

“모델의 지식과 기능은 사전 훈련 중에 거의 전적으로 학습되는 반면 정렬은 사용자와 상호 작용할 때 사용해야 하는 형식의 하위 분포를 알려줍니다.” – LIMA 논문에서 [4]

독점 LLM 모방: LIMA에 이어 GPT-3.5/4 출력의 소규모 합성 미세 조정 데이터 세트에 대해 LLaMA를 미세 조정하여 수많은 고품질 미세 조정 LLM(예: Alpaca, Vicuna, Koala, Orca 등)이 생성되었습니다. 이러한 방식으로 우리는 더 강력한 LLM의 결과를 모방하도록 이러한 모델을 훈련할 수 있습니다. 인간 실험과 단순한 벤치마크에서 평가했을 때 이러한 모델은 ChatGPT와 같은 강력한 모델의 성능과 일치(또는 초과)하는 것처럼 보였습니다. 이러한 이유로 실무자들은 소량의 (저렴한) 미세 조정을 수행하면 GPT-4 또는 ChatGPT와 같은 모델을 능가할 수 있다고 믿기 시작했습니다.

여기서 무슨 일이 일어나고 있는 걸까요? 분명히 ChatGPT와 같은 모델을 훈련하는 것은 쉽지 않습니다. 연구자들은 모방 모델에 대한 작업에서 몇 가지 한계를 빠르게 발견했습니다. [5]:

– LLM의 스타일이 좋으면 인간은 쉽게 속고, (LIMA에서 볼 수 있듯이) 이러한 모델은 적은 데이터로 ChatGPT와 같은 모델의 스타일을 모방하는 방법을 빠르게 학습할 수 있습니다.

– 사용된 벤치마크가 너무 제한적입니다. 이 모델은 소규모 그룹의 인간이 평가할 때 잘 수행되지만 전통적인 난제 기반 평가(예: 일반 NLP 벤치마크)를 포함하는 보다 광범위한 벤치마크에서는 성능이 떨어집니다.

소량의 데이터에 대한 미세 조정을 통해 특정 사항(예: 스타일 및 출력 형식)을 배울 수 있지만 모든 것을 배울 수는 없습니다. 이러한 모방 모델에는 대량의 데이터를 통해서만 학습할 수 있는 보다 강력한 LLM의 지식 기반이 부족합니다.

모든 것을 종합하면: 지금까지 다룬 모든 정보를 바탕으로 추론할 수 있는 몇 가지 시사점은 다음과 같습니다.

- LLM의 대부분의 지식은 사전 교육에서 비롯됩니다.

- 우리는 LLM을 더 많은 (그리고 새로운) 데이터/지식에 노출시키기 위해 지속적인 사전 훈련의 형태로 미세 조정을 수행할 수 있습니다.

- 소규모 고품질 데이터 세트에 대한 미세 조정(SFT)을 통해 정렬 중심 목표를 달성할 수 있습니다. 출력의 스타일이나 형식을 배우기 위해 엄청난 양의 데이터가 필요한 것이 아니라 새로운 지식을 배우기 위해서만 필요합니다.

미세 조정을 수행할 때 우리가 목표로 하는 목표(정렬 또는 지식 주입)가 무엇인지 아는 것이 매우 중요합니다. 그런 다음 해당 목표가 달성되었는지 여부를 정확하고 종합적으로 평가할 수 있는 벤치마크를 마련해야 합니다. 모방 모델은 이를 수행하지 못하여 오해의 소지가 있는 주장/결과가 많이 발생했습니다!

진행 중인 작업: 이야기는 여기서 끝나지 않습니다! 실제로 사전 훈련과 미세 조정의 구분은 여전히 매우 모호합니다. LLM은 어떤 시점에서 스타일/정렬을 배우는 대신 실제로 새로운 지식을 배우기 시작합니까? 최근의 많은 출판물에서는 이 질문을 계속해서 연구하고 있습니다.

- 미세 조정과 RAG 비교 [6]: 저자는 지속적인 사전 훈련이 지식 주입에 매우 효과적이지 않은 반면 RAG는 실제로 LLM을 새로운 지식 기반으로 전문화하는 데 매우 효과적이라는 것을 발견했습니다.

- 한계 [7]: MosiacML/Databricks의 저자는 명령 조정과 정렬 중심 데이터의 작은 혼합에 대해 미세 조정을 수행하여 NLP 벤치마크와 스타일 중심 평가 모두에서 좋은 성능을 보이는 모델을 만들 수 있음을 보여줍니다.

- 툴루 [8]: 저자는 미세 조정된 LLM을 더 폭넓게 평가하여 기본 모델의 품질이 성능에 막대한 영향을 미치며 데이터 세트/전략을 미세 조정하면 모든 벤치마크에서 최상의 결과를 얻을 수 없다는 사실을 발견했습니다.

- 툴루-2 [9]: 저자는 특정 데이터 세트에 대해 LLM을 미세 조정하면 모델이 특정 기술과 데이터 영역을 학습하게 된다는 것을 보여줍니다. 미세 조정 데이터 세트가 우리가 사용하는 평가 스타일/영역과 매우 관련이 있는지 확인하면 미세 조정이 잘 작동합니다.

- 알파가수스 [10]: 저자는 LLM이 다양한 다운스트림 작업을 잘 수행하는 데 얼마나 많은 미세 조정 데이터가 필요한지 직접 연구합니다.

서지:

[1] 웨이, 제이슨, 등. “미세 조정된 언어 모델은 제로샷 학습자입니다.” arXiv 사전 인쇄 arXiv:2109.01652 (2021).

[2] 투브론(Touvron), 휴고(Hugo) 등. “Llama: 개방적이고 효율적인 기초 언어 모델.” arXiv 사전 인쇄 arXiv:2302.13971 (2023).

[3] 투브론(Touvron), 휴고(Hugo) 등. “Llama 2: 개방형 기반 및 미세 조정된 채팅 모델.” arXiv 사전 인쇄 arXiv:2307.09288 (2023).

[4] Zhou, Chunting, 그 외 여러분. “리마: 정렬에는 적을수록 좋습니다.” 신경 정보 처리 시스템의 발전 36(2024).

[5] Gudibande, Arnav 등. “독점 LMS를 모방한다는 잘못된 약속.” arXiv 사전 인쇄 arXiv:2305.15717 (2023).

[6] Ovadia, Oded 등. “미세 조정 또는 검색? llms의 지식 주입 비교.” arXiv 사전 인쇄 arXiv:2312.05934 (2023).

[7] Jha, Aditi, 그 외 여러분. “한계: 평가 패러다임 전반에 걸친 교육 조정에는 적은 것이 더 좋습니다.” arXiv 사전 인쇄 arXiv:2311.13133 (2023).

[8] 왕(Wang), 이중(Yizhong) 등. “낙타는 어디까지 갈 수 있나요? 공개 리소스에 대한 교육 조정 상태를 탐구합니다.” 신경 정보 처리 시스템의 발전 36(2024).

[9] Ivison, Hamish 등. “변화하는 기후 속의 낙타: 툴루 2를 통해 작품 적응력 향상.” arXiv 사전 인쇄 arXiv:2311.10702 (2023).

[10] Chen, Lichang, 등. “알파가수스: 더 적은 데이터로 더 나은 알파카를 훈련시키세요.” arXiv 사전 인쇄 arXiv:2307.08701 (2023).

Post Comment