6GB의 VRAM이있는 게임 GPU로 AI 생성 비디오가 가능합니다.

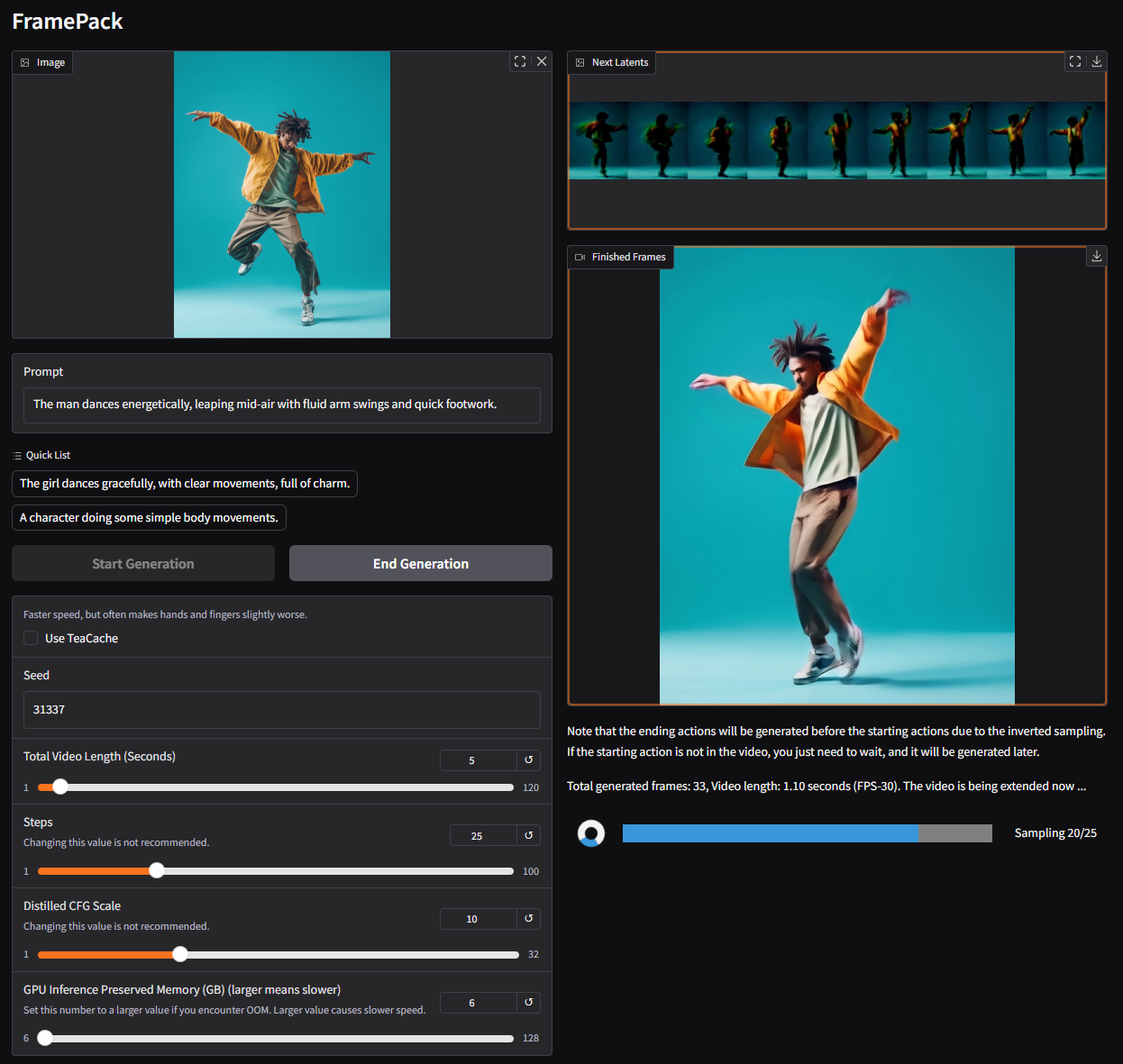

lvmin Zhang 및 기럽Stanford University의 Maneesh Agrawala와 협력하여 이번 주 Framepack을 소개했습니다. Framepack은보다 효율적인 처리를 위해 고정 길이의 시간 컨텍스트를 사용하여 비디오 확산의 실질적인 구현을 제공하여 더 길고 고품질의 비디오를 가능하게합니다. Framepack 아키텍처를 사용하여 구축 된 130 억 개의 매개 변수 모델은 6GB의 비디오 메모리만으로 60 초 클립을 생성 할 수 있습니다.

Framepack은 다단계 최적화 기술을 사용하여 로컬 AI 비디오 생성을 가능하게하는 신경망 아키텍처입니다. 글을 쓰는 시점에서 Framepack GUI는 후드 아래에서 맞춤형 hunyuan 기반 모델을 실행한다고합니다. 그러나 연구 논문은 기존 미리 훈련 된 모델이 Framepack을 사용하여 미세 조정할 수 있다고 언급합니다.

일반적인 확산 모델은 이전에 생성 된 노이즈 프레임의 데이터를 처리하여 다음, 약간 덜 시끄러운 프레임을 예측합니다. 각 예측에 대해 고려 된 입력 프레임의 수를 시간 컨텍스트 길이라고하며 비디오 크기로 증가합니다. 표준 비디오 확산 모델에는 12GB가 일반적인 출발점이되는 대형 VRAM 풀이 필요합니다. 물론 메모리가 줄어들 수는 있지만 클립이 짧은 비용, 품질이 낮고 처리 시간이 길어집니다.

Framepack 입력 : 중요성에 따라 입력 프레임을 고정 크기 컨텍스트 길이로 압축하여 GPU 메모리 오버 헤드를 크게 줄입니다. 모든 프레임은 컨텍스트 길이에 대한 원하는 상한에서 수렴하기 위해 압축되어야합니다. 저자는 계산 비용을 이미지 확산과 유사하게 설명합니다.

Framepack은 비디오 길이로 품질이 저하되는 “표류”를 완화하는 기술과 함께 충실도에 대한 상당한 타협없이 더 긴 비디오 생성을 제공합니다. Framepack은 FP16 및 BF16 데이터 형식을 지원하는 RTX 30/40/50 시리즈 GPU가 필요합니다. AMD/Intel 하드웨어에 대한 언급없이 튜링 및 구조 아키텍처에 대한 지원은 확인되지 않았습니다. Linux는 지원되는 운영 체제 중 하나입니다.

RTX 3050 4GB 외에도 대부분의 현대 (RTX) GPU는 6GB 기준을 충족하거나 초과합니다. 속도 측면에서 RTX 4090은 0.6 프레임/초 (Teacache로 최적화)를 요리 할 수 있으므로 그래픽 카드에 따라 마일리지가 다릅니다. 어느 쪽이든, 각 프레임은 생성 된 후에 표시되며 즉각적인 시각적 피드백을 제공합니다.

고용 된 모델에는 30 FPS 캡이있을 수 있으며, 이는 많은 사용자에게 제한 될 수 있습니다. 즉, Framepack은 값 비싼 타사 서비스에 의존하는 대신 AI 비디오 생성을 일반 소비자에게보다 쉽게 액세스 할 수 있도록하는 길을 열고 있습니다. 콘텐츠 제작자가 아니더라도 GIF, 밈 등을 만드는 재미있는 도구입니다. 나는 내가 자유 시간에 그것을 줄 것임을 압니다.

Post Comment